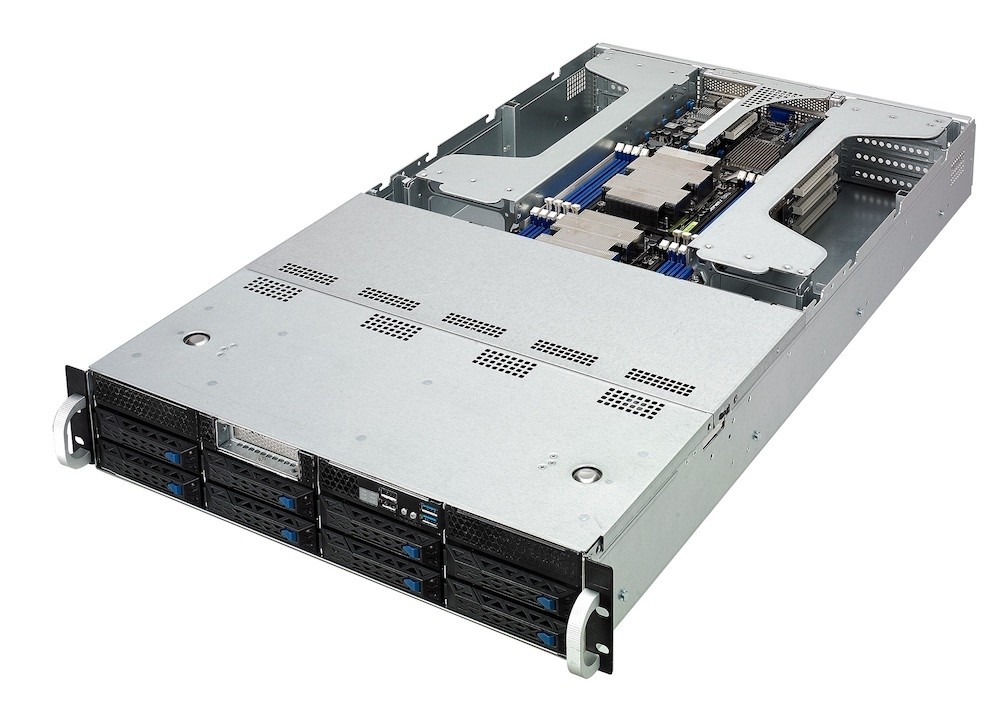

近年來 AI 人工智慧演進已持續將資料轉為有意義的見解、服務及科學突破,推動 AI 革命的神經網路規模亦有大幅成長,例如目前用於語言翻譯的 Google MOE 神經網路模型從兩年前的 1 億個參數進展到 80 億個。為了因應 AI 人工智慧不斷進化、成熟, 華碩 今日 (5/30) 宣布旗下 GPGPU 伺服器、通用伺服器均可支援最新 NVIDIA AI 人工智慧解決方案 Tesla GPU (Tesla V100 32GB 與 Tesla P4),將為使用者帶來最極致的體驗。

此次 NVIDIA 新推出的 Tesla V100 具備 32GB 記憶體,可提升新一代 AI 模型深度學習效能達 50%,而 Tesla P4 為全球最快的深度學習推理 GPU,可減少 10 倍推理延遲,以及提供比 CPU 高出 40 倍的能源效率,安裝於橫向擴展伺服器上,能實現兼具智慧與互動性的 AI 服務應用。

華碩的 GPGPU 伺服器及通用伺服器則是全面支援 Tesla V100 32GB、Tesla P4,其中 ESC8000 G4 可以支援 8 張 Tesla V100 32GB、ESC4000 G4 則是可以支援 4 張 Tesla V100 32GB 或 8 張 Tesla P4,至於 RS720-E9,則可支援 Tesla P4,透過絕佳的推理能力,滿足各種 AI 負載需求。